Индексирование сайтов: основные принципы. Как, зачем и почему

Основные принципы индексации сайтов

Автор: Webakula

Узнайте все тонкости индексации сайтов и как можно ускорить индексацию.

Зачем нужен сайт? Чтобы люди получали интересующую их информацию. Но ресурсов в сети множество, а дальше первых двух страниц поиска люди продвигаются редко. Соответственно, чтобы пользователь увидел именно ваш ресурс, он должен находиться в верхней части выдачи. Эту задачу решает продвижение в поисковиках.

А индексация - важная часть продвижения, подразумевающая считывание сведений с ресурса, их обработку алгоритмами поиска и помещение результатов обработки в базу данных поисковика.

Процесс индексирования можно улучшить. То есть так упаковать информацию, чтобы она лучше усвоилась ПС.

Индексирование сайта: начало

Индексирование не начнется, пока робот поисковика не узнает о новом ресурсе в своих «владениях». Сообщить ему можно, зарегистрировав ресурс в нужных поисковых системах по ссылкам: webmaster.yandex.ru/addurl.xml и google.com/webmasters/tools/submit-url?hl=ru для Яндекса и Гугла соответственно.

Индексирование не начнется, пока робот поисковика не узнает о новом ресурсе в своих «владениях». Сообщить ему можно, зарегистрировав ресурс в нужных поисковых системах по ссылкам: webmaster.yandex.ru/addurl.xml и google.com/webmasters/tools/submit-url?hl=ru для Яндекса и Гугла соответственно.

Или можно дать ссылку с уже зарегистрированного сайта на новый.

Регистрация непосредственно на ПС гарантирует, что индексация произойдет быстрее.

Частота индексирования: возможность ускорения

Миллиарды веб-адресов из базы данных Яндекса не могут индексироваться каждый день. Соответственно, существует определенная периодичность индексации.

Миллиарды веб-адресов из базы данных Яндекса не могут индексироваться каждый день. Соответственно, существует определенная периодичность индексации.

Но периодичность индексирования – непостоянная величина. Поэтому оказывается, что на некоторых ресурсах изменения отслеживаются постоянно, а другие практически не посещаются поисковыми роботами.

Можно уменьшить интервал индексирования, что позволит эффективно продвигать сайт. Ведь любое изменение будет оперативно приводить к нужному результату.

Как обеспечить оперативность индексирования? Следует знать, какие факторы влияют на нее:

- Качество хостинга: чем загруженнее сервер, хранящий ваш сайт, тем реже его будет посещать робот ПС. Ведь из-за загрузки техническая информация передается медленно.

- Частота обновления ресурса: считайте, что роботу «интересно» посещать те места, где постоянно происходят перемены. А если обновлений нет, то и регулярного индексирования ждать не стоит. Однако учитывайте, что индексироваться будут именно страницы с обновлениями. Поэтому лучше дополнить главную страницу блоком новостей, и динамика всему ресурсу обеспечена.

- Посещаемость, поведенческие факторы: если люди приходят на ресурс, задерживаются, подписываются и так далее, то такой сайт автоматически будет «на виду» у ПС, и интервалы между индексированиями сократятся.

Важно, что на каждый из этих факторов можно влиять, делая ресурс «гостеприимным» для роботов из ПС.

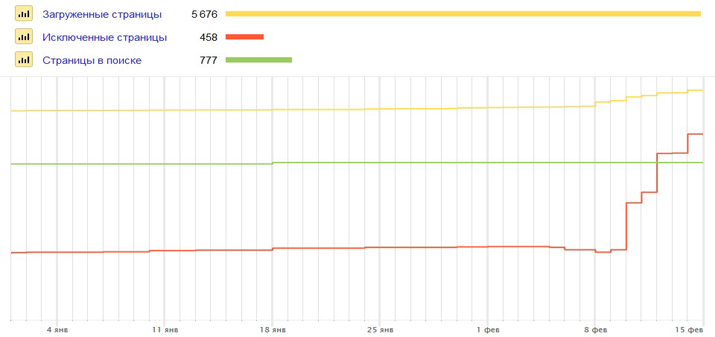

Проверяем индексацию сайта: основные способы

Как отследить эффективность ваших действий? Для этого следует знать, когда прошла индексация. Проверяют это определенными ресурсами.

Как отследить эффективность ваших действий? Для этого следует знать, когда прошла индексация. Проверяют это определенными ресурсами.

Например, на Яндекс.Вебмастер – в разделе проверки URL вы узнаете, когда прошла индексация, почему страницы нет в поиске или какой документ видит пользователь в ПС. Также здесь даются рекомендации по ускорению индексирования.

Проверку проводят и с помощью sait:. Для этого вводят в строку поиска sait: moi sait.ru и получите все проиндексированные страницы списком.

Проверить индексацию URL можно и с помощью SE Ranking. Здесь есть инструмент, позволяющий следить за заданным URL в поиске. Благодаря ему отслеживают, демонстрируется ли требуемая страница пользователям и есть ли она в поиске вообще.

Правила управления роботом ПС

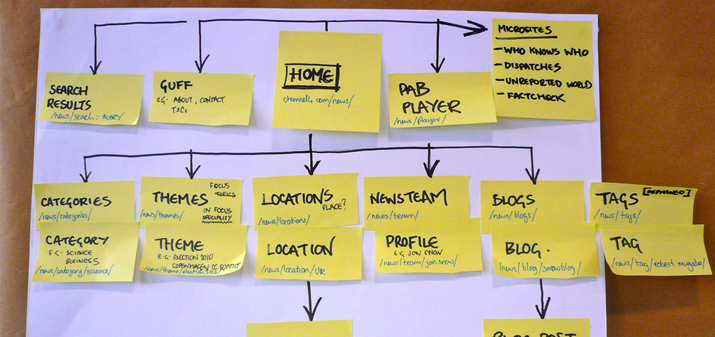

Информация с сайта скачивается по алгоритму – и никакие вольности здесь не допускаются. А план расположен именно на ресурсе, и никак иначе. Получается, именно вы указываете роботу, что скачивать, а что – нет.

Информация с сайта скачивается по алгоритму – и никакие вольности здесь не допускаются. А план расположен именно на ресурсе, и никак иначе. Получается, именно вы указываете роботу, что скачивать, а что – нет.

Например, никогда нельзя позволять роботам проверять личную информацию клиентов. Для этого предусмотрен специальный файл, указывающий те страницы, что не индексируются.

Используйте строку Disallow:/admin, чтобы не посматривались страницы, начинающиеся с admin, а строка Disallow:/images введет запрет на индексирование картинок.

Если вы укажете в robots.txt адрес sitemap, то позволите роботу просматривать все страницы, где нет запрета индексации.

Но часто в robots.txt допускаются ошибки. Самая распространенная из них – это ошибочный запрет индексирования.

Также это могут быть:

- Некорректный код HTTP-ответа. Если он будет отличаться от 200, то robots.txt может не учитываться.

- Если в записи окажется кириллица, то файл проигнорируется. Урл сайта, записанный кириллическими буквами, передают в юникоде;

- Превышение размера - файл должен быть не более 32 кб.

Простым лендингам он не нужен. Если же вашему ресурсу он необходим, то проверьте корректность на специальной странице Яндекса - webmaster.yandex.ru/robots.xml. Нужно загрузить файл, и все ошибки «проявятся» автоматически.

Работа с sitemap

Это файл, где указано, какие страницы индексируются. Здесь можно использовать специальные теги для контроля за индексацией. Так, тег

Это файл, где указано, какие страницы индексируются. Здесь можно использовать специальные теги для контроля за индексацией. Так, тег

позволяет указать приоритетную страницу, а указывает частоту обновления.

Файл sitemap должен размещаться на вашем ресурсе. Здесь не должно быть критических ошибок.

Правильность создания этого сайта тоже можно проверить в Яндексе –webmaster.yandex.ru/ sitemaptest.xml.