Проводимо SEO-аудит сайту – частина перша

Багато хто вважає, що просування сайтів – це дрімучий ліс, у якому легко заблукати недосвідчений мисливець за високим трафіком. Насправді все так і є :) Однак ми наполегливо рекомендуємо «не боятися вовків» і поринути з нами у захоплюючий шлях по етапах аналізу технічних характеристик ресурсу з погляду SEO.

Багато хто вважає, що просування сайтів – це дрімучий ліс, у якому легко заблукати недосвідчений мисливець за високим трафіком. Насправді все так і є :) Однак ми наполегливо рекомендуємо «не боятися вовків» і поринути з нами у захоплюючий шлях по етапах аналізу технічних характеристик ресурсу з погляду SEO.

Для початку непогано б скласти загальне уявлення про ресурс, проаналізувавши внутрішні та зовнішні посилання, код, зображення, контент та інші складові сайту за допомогою кількох зручних сервісів:

- Яндекс.Вебмайстер;

- Google Webmaster Tools;

- Xenu's Link Sleuth;

- Screaming Frog SEO Spider.

Отримавши стільки цінної інформації, можна «топати» далі, щоб розглянути складові ресурсу ретельніше.

Файл robots.txt

Robots.txt, він же стандарт вилучення роботів, міститься в корені сайту, використовується для налаштування індексації ресурсу. Файл дозволяє закрити для пошукових роботів доступ до певних сторінок або сайту повністю. Крім того, у нього є безліч інших корисних налаштувань:

- визначення головного дзеркала сайту;

- вказівка шляху до картки сайту (sitemaps.xml) для правильної індексації;

- кількість завантаження сторінок за певний час;

- заборона доступу для певних пошукових систем або різних роботів тієї ж пошукової системи.

Можна створити безліч правил сканування в залежності від цілей та побажань власника сайту.

З усього вищевикладеного зрозуміло, що robots.txt є архіважливим атрибутом просування. Під час аналізу сайту переконайтеся, що файл правильно налаштований, а сторінки-дублі або розділи з неякісним контентом не індексуються. У цьому допоможуть ті самі «Яндекс.Вебмайстер» і Google Webmaster Tools.

Sitemap

XML Sitemap теж знаходиться в кореневій директорії, від нього залежить коректність та швидкість індексації всіх сторінок сайту. Завдяки цьому файлу пошукові системи дізнаються, які сторінки слід досліджувати в першу чергу і як часто вони оновлюються.

Особливо важливим є Sitemap для сайтів з великою кількістю сторінок. Важливо вказати роботу на пріоритетність тих чи інших розділів по відношенню до інших, оскільки сам він не завжди може знайти всі сторінки та визначити їхню значимість. Проводячи SEO-аудит, необхідно перевірити коректність коду цієї складової сайту за допомогою валідатора в інструментах для вебмайстрів від Google та Яндекс.

Файл Sitemap не повинен перевищувати 10 Мб і містити більше 50 тисяч посилань. У разі перевищення цього ліміту необхідно створити кілька файлів Sitemap, один із яких (Sitemap Index) міститиме списки всіх карток.

Може статися і так, що карти сайту немає, тоді її обов'язково потрібно створити вручну або за допомогою спеціальних сервісів. Потім необхідно додати шлях до Sitemap у файл robots.txt і повідомити про карту пошуковиків за допомогою інструментів, що вже не раз згадувалися, для власників сайтів.

Якість індексації сайту

Дізнатися скільки сторінок сайту проіндксував пошуковик допоможе команда site:, вона обмежує пошук одним доменом. Отже, у видачі будуть відображатися всі відскановані сторінки ресурсу. Введіть «site:» + доменне ім'я без запитів, потім порівняйте кількість просканованих сторінок з реальною кількістю сторінок сайту.

Ресурс добре проіндексований, якщо обидва числа практично однакові. Якщо ж пошук видав набагато більше посилань, ніж є насправді, то, скоріше за все, на сайті багато дубльованого контенту. Можливо і так, що сторінок у видачі набагато менше. Ймовірні причини поганої індексації:

- на сайті багато закритих для сканування сторінок;

- ресурс не оптимізований для пошукових систем;

- сайт потрапив під санкції пошукових систем

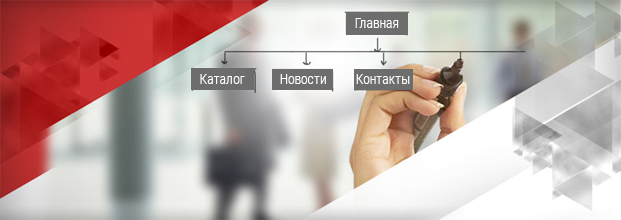

Сторінки сайту

Обов'язково необхідно перевірити код стану HTTP – відсутність помилок 404 (сторінку не знайдено), 500 (внутрішня помилка сервера), 503 (сервіс недоступний) тощо. Впоратися з цим допоможе зручний інструмент HTTP Header Status Checker від Monitor Backlinks, а також сервіси, що набили оскому в цій статті для власників сайтів від Google та Яндекс.

В ідеалі всі URL на сайті повинні відповідати вимогам SEO:

- складатися з слів, що легко читаються;

- мати довжину 100-120 символів;

- містити ключові слова відповідні сторінці;

- поділ слів дефісами;

- прості адреси без параметрів (переважніше статичні посилання);

- використання директорій, а не субдоменів для розділів сайту.

Перевірка цих параметрів і суворе дотримання потрібні і для кращого індексування сайту, і для зручності відвідувачів.

Швидкість завантаження сайту

Важливий аспект як для нетерплячих користувачів, але й пошуковиків. Останні швидше і ретельніше індексують спритні ресурси, оскільки вони лімітовано час, відведений на сканування.

Переглянути звіти про швидкість завантаження сторінок можна у засобах веб-аналітики Яндекс та Google. Більш детальну інформацію можна отримати на спеціальних сервісах, наприклад, на YSlow та Google PageSpeed Insights.

SEO-аудит сайту – непростий та трудомісткий процес, закономірно, що всі його пункти не умістилися в одну статтю. У наступній нашій публікації ми розповімо про зовнішній SEO-аналіз ресурсу, аудит структури та контенту сайту.